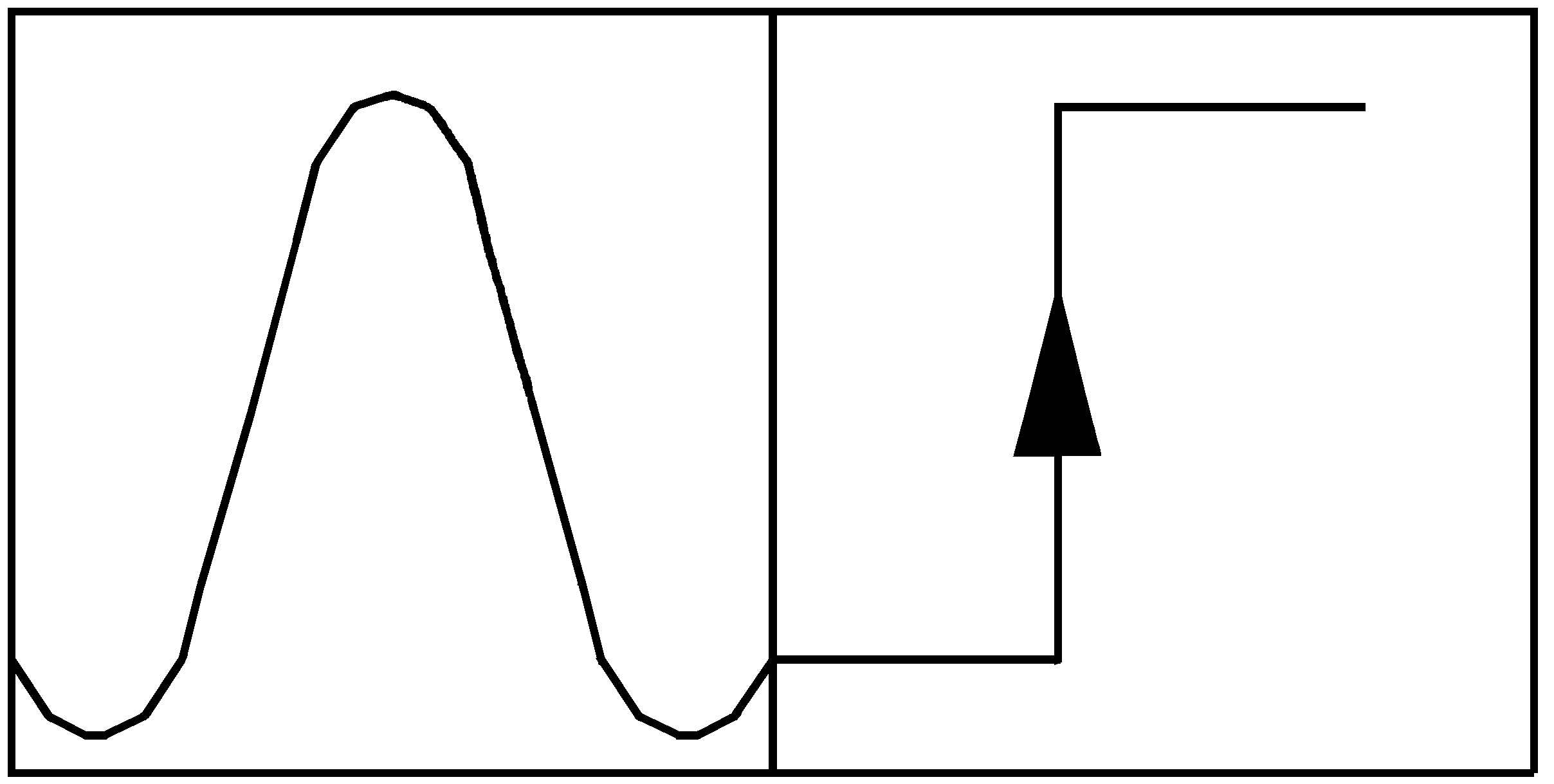

Der Computer arbeitet nur mit binären (zweiwertigen) Spannungssignalen. Ein eizelnes Spannungssignal kann zwei Werte annehmen, der eine Wert wird als „0“ und der andere Wert als „1“ interpretiert, fertig ist das Bit. „Bit“ ist ein Kunstwort und steht allgemein für „Binary Digit„, eben eine binäre Ziffer.

Eine Gruppe dieser Spannungssignale lassen sich nun als binäre Zahlen interpretieren. Eine Gruppe von vier Bit bezeichnet man auch als Nibble. Und eine Gruppe von acht Bit nennt man „Byte„.

Mit einem Byte (= 8 Bit) kann man 256 verschiedene Zustände codieren. Eine Form der Codierung ist es, diesen 256 Zahlenwerten (von 0 bis 255) bestimmte Zeichen zuzuordnen, nämlich Buchstaben, Zifferzeichen, Satzzeichen, Sonderzeichen etc.

ASCII

Das Ergebnis ist ein sogenannter „Zeichensatz„. Der wohl bekannteste Zeichensatz ist die ASCII-Codierung, die durch sieben Bit kodiert ist (7 Bit Zeichensatz). ASCII steht hierbei für „American Standard Code for Information Interchange„, also „Amerikanischer Standard-Code für Informationsaustausch“. Da die CPUs eine ganze Weile über acht interne Datenleitungen verfügten (8 Bit), wurden auf der Grundlage der ASCII-Tabelle, die mit ihren 7 Bit insgesamt 128 Zeichen kodieren kann, weitere Zeichensätze bzw. Zeichensatztabellen definiert, bei denen das zur Verfügung stehende achte Bit weitere 128 Zeichen kodieren konnte.

BCD

Eine deutlich kürzere Kodierung mittels vier Bit, ist der sogenannte „BCD-Code“ (Binary Coded Decimal).Hiermit werden die 10 Zahlzeichen des Dezimalsystems kodiert: 0000₂ = „0“, 0001₂ = „1“, 0010₂ = „2 … 1001₂ = „9“. Von den 16 möglichen Binärkombinationen (0000₂ bis 1111₂) werden nur zehn Kombinationen verwendet; die verbleibenden sechs Kombinationen werden als „Pseudotetraden“ bezeichnet. Der BCD-Code wird in der Elektronik häufig zur Darstellung der Zahlzeichen mit Hilfe von sogenannten „7-Segment-Anzeigen“ verwendet. Hierzu existieren fertige „Integrierte Schaltungen“ (ICs), die als Eingangsgröße den BCD-Code verwenden und damit die sieben Segmente einer solchen Anzeigeeinheit ansteuern.

Unicode

Mit dem Ziel, alle möglichen Schrift- und Sonderzeichen zu codieren, wurde der sogenannte „Unicode“ entwickelt und standardisiert in einer ISO-Norm. Für die Kodierung werden unterschiedlich viele Bit (8, 16, 32) verwendet. Mittlerweile wurde der ASCII-Code durch den Unicode „UTF-8“ als Standard weitestgehend abgelöst. Die ersten 128 Zeichen von UTF-8 sind identisch mit ASCII.

Nachfolgend mein Arbeitsblatt als PDF:

Und noch eine übersichtliche ASCII-Tabelle sowie diverse Zeichensätze als PDF. Die Quelle ist im Dokument zu finden: